近期,ChatGPT风潮之下,微软、谷歌及百度等一众厂商“神仙打架”,市场对训练和部署人工智能软件所需芯片的需求飙升,英伟达H100为代表的算力芯片价格水涨船高,在美国电商平台eBay上的售价已经超过4万美元,甚至有些卖家标价高达6.5万美元。

3月21日,英伟达在美国召开年度开发者大会(GTC)上表示,ChatGPT等生成式AI的出现,标志着AI的“iPhone”时刻来临,以英伟达H100为代表的AI 训练芯片有望迎来量价齐升。

01、英伟达DGX——AI大语言模型背后的核心引擎

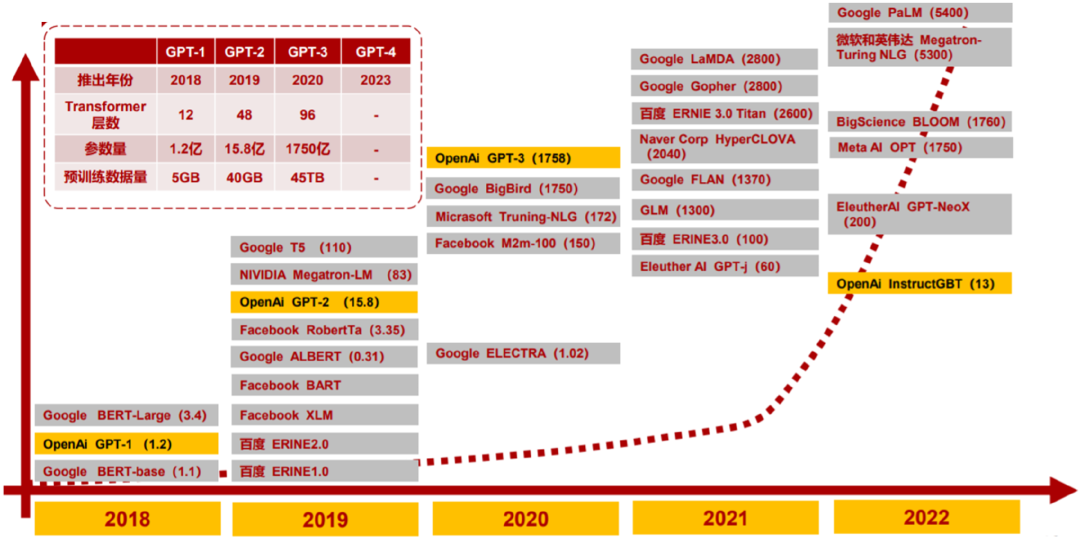

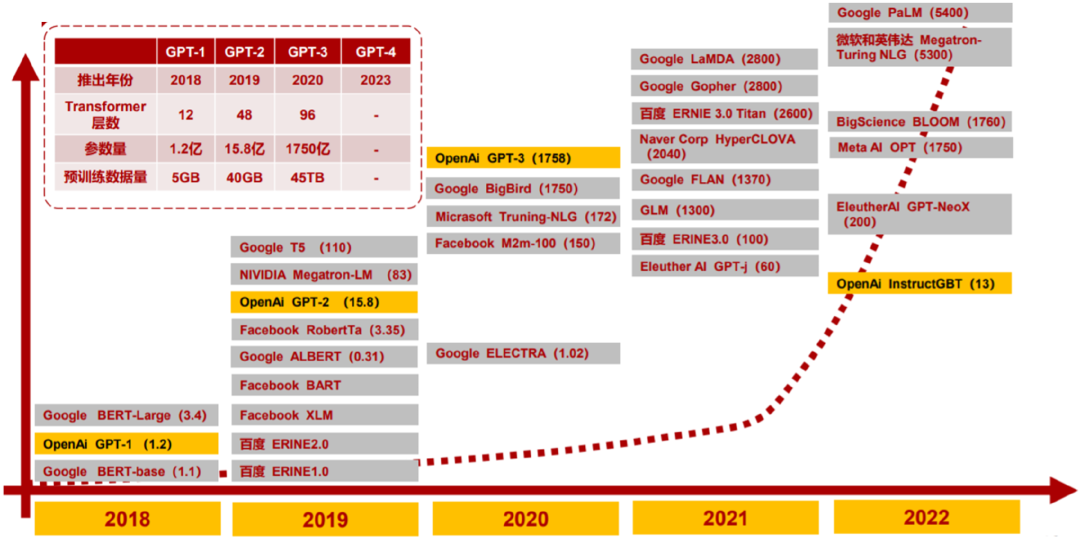

2023年3月15日,OpenAI正式官宣了多模态大模型GPT4,其能力已接近人类水平。通过以搜索引擎和办公软件为支点,AI下游应用多点开花。GPT4作为大型多模态模型支持图像和文本的输入,背后是大语言模型的演进与参数量、训练数据量的指数级增长,带动AI服务器需求量快速上涨。

AI迈入大模型时代,参数量过千亿

资料来源:浙商证券

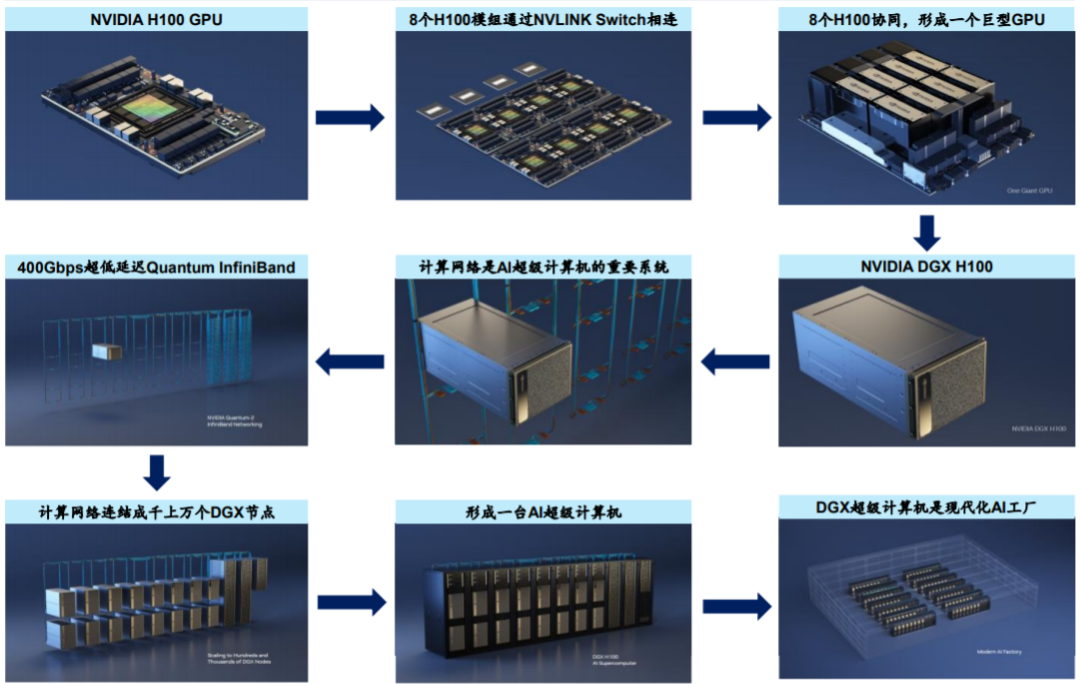

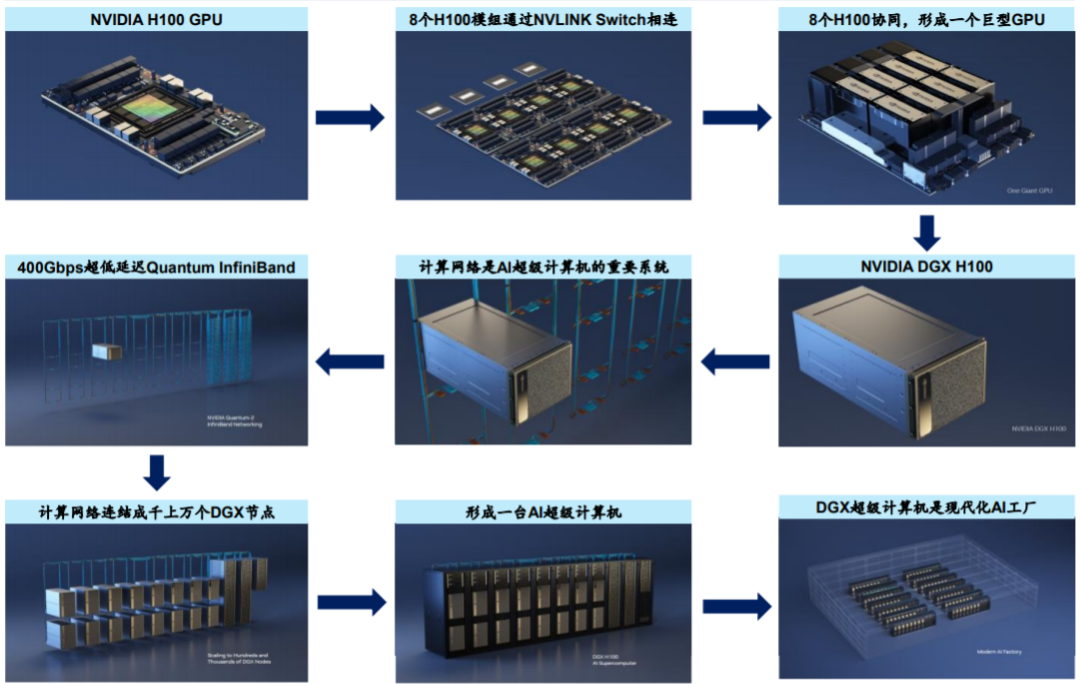

根据GTC2023,DGX配有8个H100GPU模组,H100配有Transformer引擎,旨在支持类似ChatGPT的大模型。这8个H100模组通过NVLINKSwitch彼此相连,以实现全面无阻塞通信。8个H100协同工作,形成一个巨型GPU。通过400Gbps超低延迟的NVIDIAQuantumInfiniBand进行网络内计算,将成千上万个DGX节点连接成一台AI超级计算机,并不断扩展应用范围,成为全球客户构建AI基础设施的蓝图。

NVIDIA DGXH 100 超级计算机结构

资料来源:GTC2023

根据英伟达测算,要完成一次10000亿参数大语言模型的训练,使用4096颗A100 GPU约需4周时间,使用4096颗H100GPU约需1周时间。按每台服务器配备8颗H100GPU计算,则完成一次万亿参数的大语言模型训练需约500台服务器,配备8个H100GPU的服务器价格约为40万美元,则单个大语言模型训练驱动AI训练服务器约2亿美元需求。

从下游需求看,ChatGPT、文心一言等AIGC大模型带来计算资源需求井喷,催生AI服务器需求快速增长。据IDC数据,2021年全球AI服务器市场规模156亿美元,预计到2025年全球AI服务器市场将达到318亿美元,21-25CAGR为19.5%;2021年中国AI服务器市场规模达52亿美元,预计2025年中国AI服务器市场规模将达到105亿元,2021-2025年的CAGR为19.0%。按照中高端服务器GPU占比35%-60%测算,则2025年全球AI服务器GPU芯片规模不低于111亿美元。

资料来源:IDC

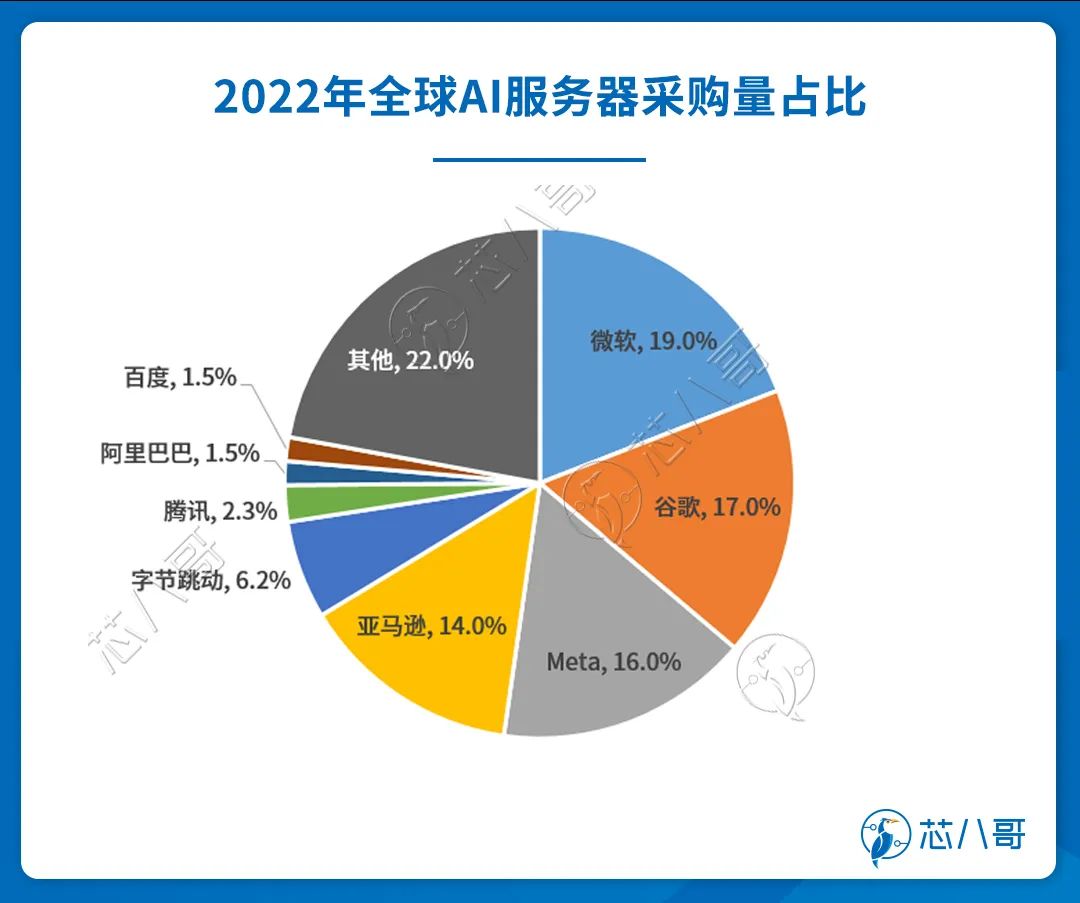

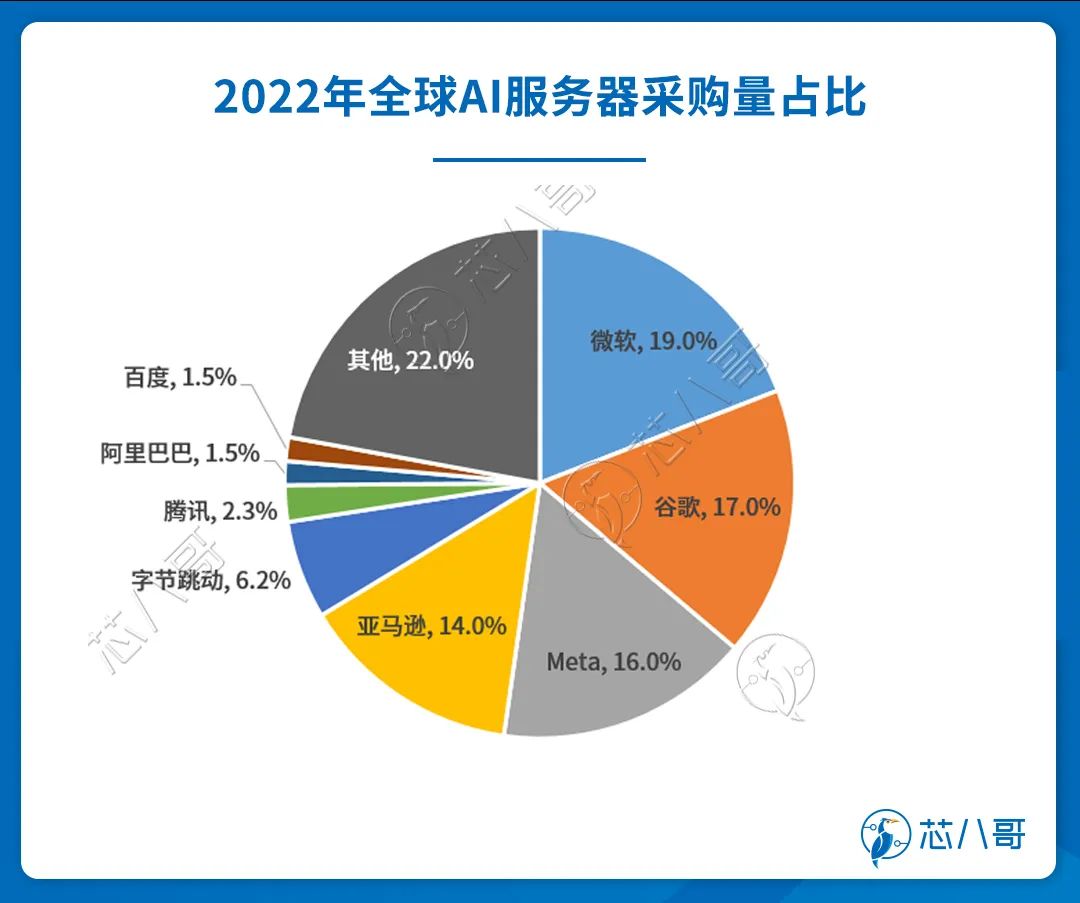

下游客户看,2022年AI服务器采购量中,北美四大云端供应商微软、谷歌、Meta、亚马逊合计占比约66%,而中国近年来AI建设浪潮持续升温,字节跳动年采购占比达6.2%,腾讯、阿里巴巴、百度紧接其后,分别约为2.3%、1.5%与1.5%。

资料来源:IDC

近期,随着市场热度及终端需求飙升,英伟达最新的显卡H100芯片在美国电商平台eBay上的售价已经超过4万美元,甚至有些卖家标价高达6.5万美元。短期来看,作为服务器GPU领导者,英伟达将直接受益于AIGC大热带来的核心算力硬件性能需求提升。

资料来源:英伟达、芯八哥整理

02、AI训练芯片竞争格局

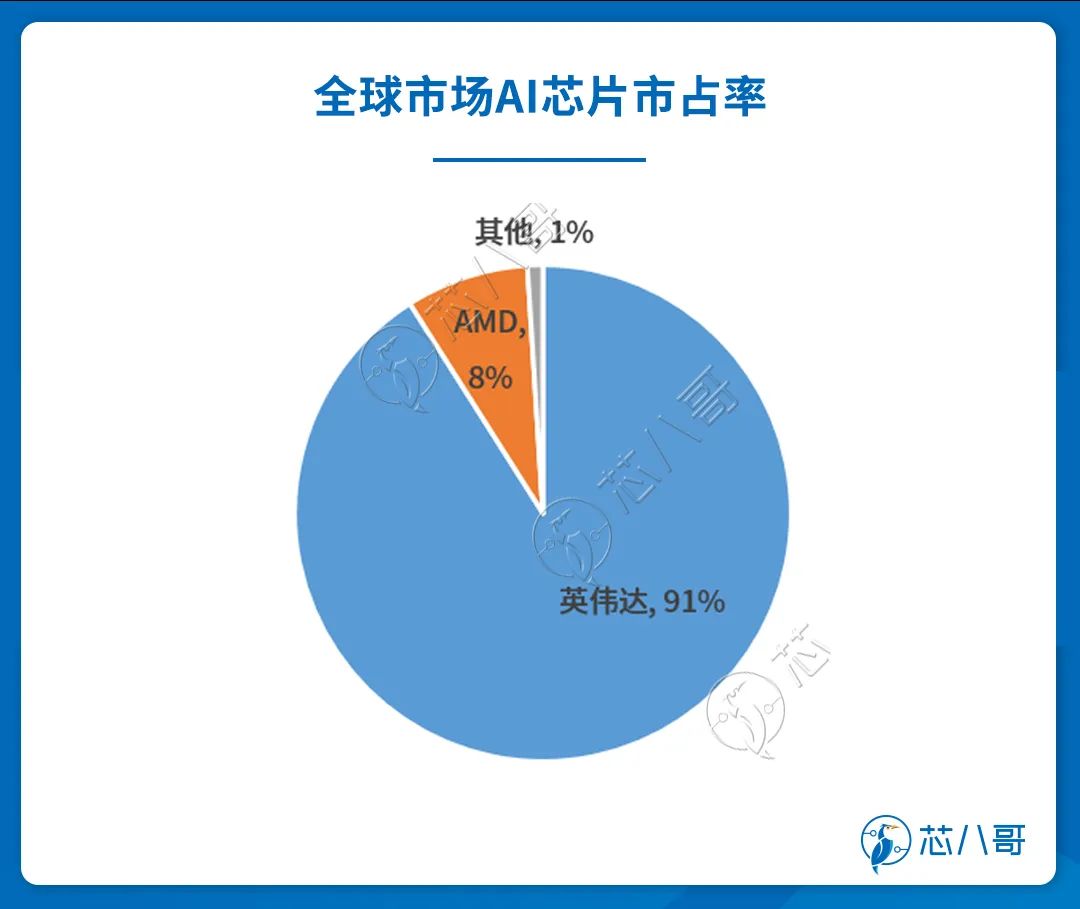

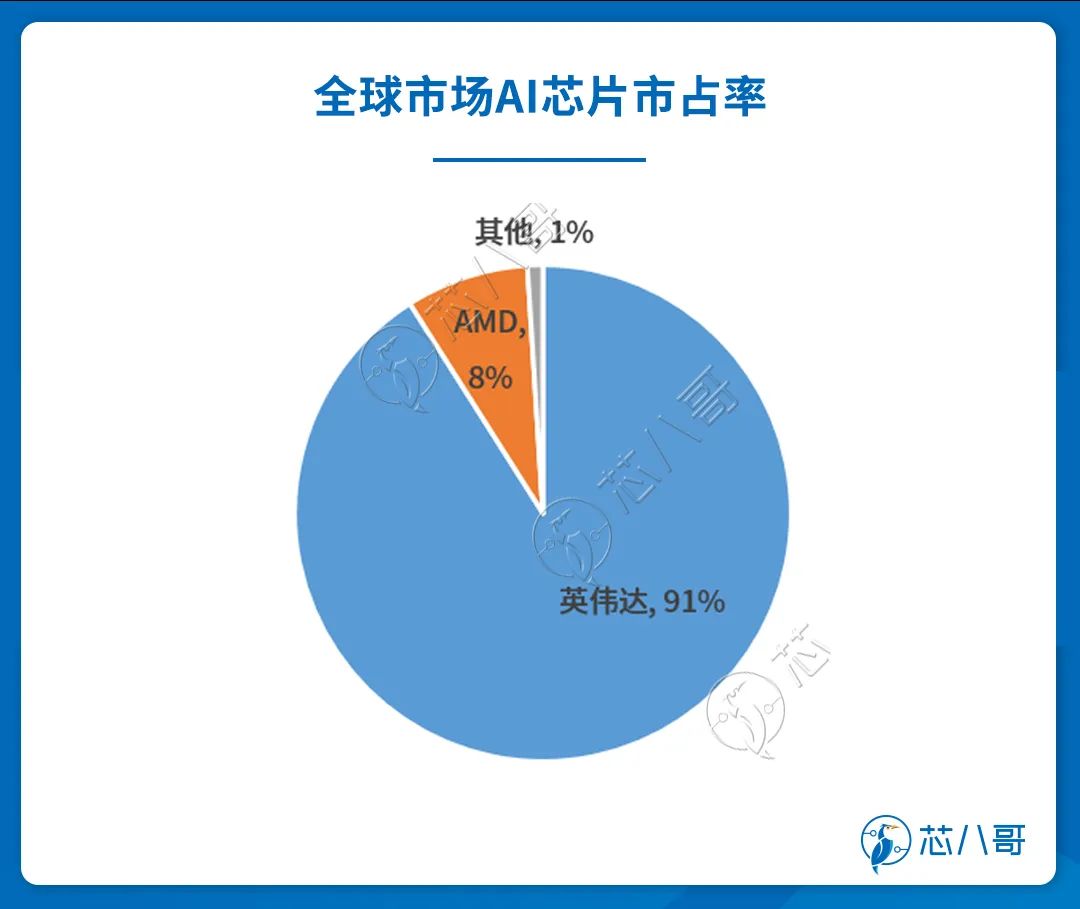

从全球市场来看,英伟达和AMD为AI训练GPU芯片领域代表性厂商,二者占据市场绝大部分份额,Intel和谷歌为代表竞争对手仍处于早期阶段。

资料来源:IDC

具体而言,目前AI训练市场主要采用英伟达V100/A100/H100芯片,以及AMD推出的AI训练芯片包括MI250/250X/300等。

资料来源:芯八哥整理

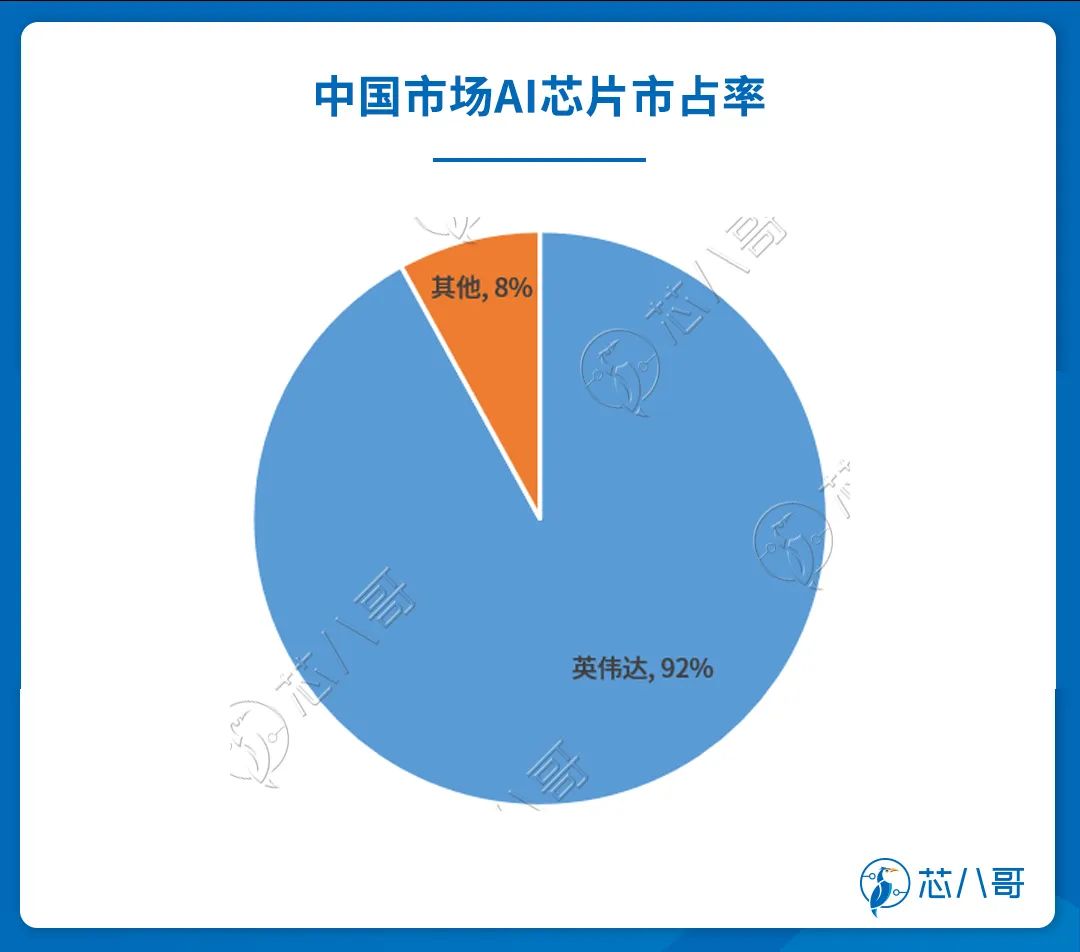

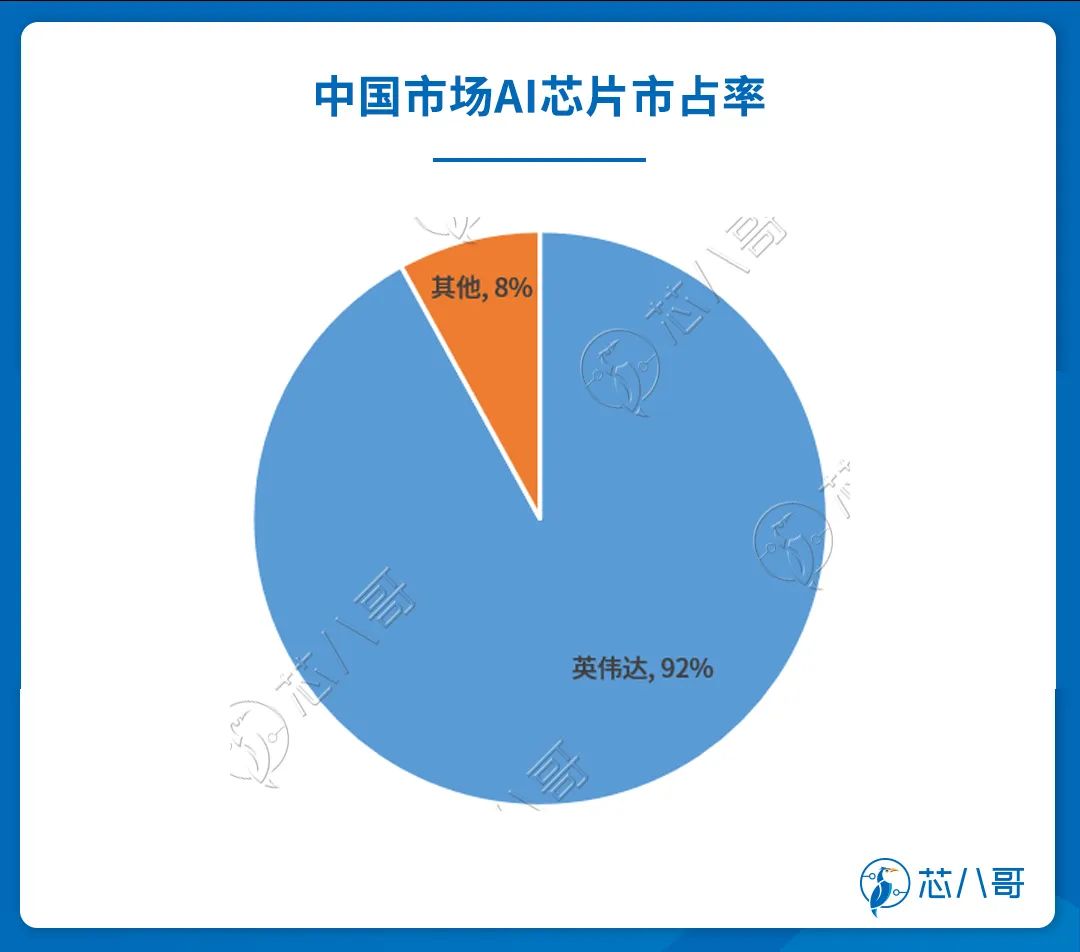

中国市场方面,英伟达占比超过92%,呈现出“一家独大”,但以寒武纪及华为海思为代表的国产厂商取得了一定突破。

资料来源:IDC

具体来看,近年来国内AI训练芯片进展较快,但与英伟达在性能和生态有一定差距。以云邃T20产品为例,其32位单精度浮点性能达32TFLOPS,高于A100的19.5TFLOPS,且在功耗上更具优势,但内存宽带不足A100的1/3,在应对机器学习和深度学习的带宽需求上仍有差距。寒武纪去年年底推出思元590系列可能在部分模型上由于其ASIC专用性表现出更优异的性能,但仍需要后期适配和技术支持。

资料来源:各公司官网、芯八哥整理

03、H100对产业格局的影响分析

当前,AI正在成为这个时代最具影响力的技术力量,各类 AI+应用即将落地,像ChatGPT对话机器人,以及特斯拉即将自动驾驶中引入AI学习框架,传统应用在引入AI后将迎来巨变。可以看到,英伟达发布H100后,逐渐完成了由 GPU 显卡供应商向软硬件一体 AI 解决方案供应商的转变后,形成了竞争对手难以企及的平台化优势。

具体来看,其相对于竞争对手而言,对于产业格局的影响力在于:

(1)硬件端产品布局齐全且性能突出,公司在数据中心业务中完成CPU+DPU+GPU的组合布局。数据中心GPU市占率遥遥领先,H100、A100等高端训练卡供不应求,且性能大幅度领先竞争对手AMD的同代产品,而英特尔仍处于起步阶段。

(2)软件端前瞻布局,竞争对手稀少。CUDA平台是目前最适合深度学习、AI训练的GPU架构。主要竞争对手AMD的ROCm平台在用户生态和性能优化上还存在差距。其本身丰富的工具、领先的技术叠加没有竞争对手的先发优势将持续巩固公司在元宇宙以及数字工业领域的优势。

短期内,AIGC产品与应用的步落地催生了巨大的算力需求,英伟达将直接受益于AIGC大热带来的核心算力硬件性能需求提升,H100为代表的业务有望迎来量价齐升。

长期来看,以H100为代表的软硬件结合的平台化布局随着未来AI应用范围的深入和拓展,英伟达有望成为平台化布局的最大受益者。